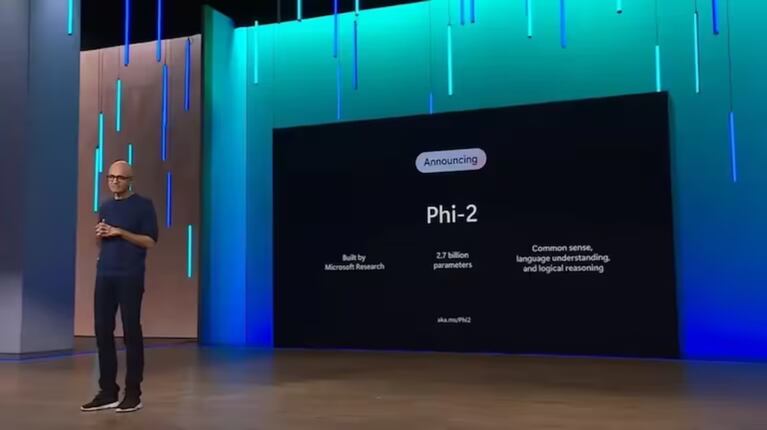

Microsoft presentó su nueva Inteligencia Artificial potenciada por un modelo de lenguaje pequeño, Phi-2, que utiliza 2,7 mil millones de parámetros.

A través de dichos parámetros, logra alcanzar capacidades de razonamiento y comprensión de lenguaje con un rendimiento igual o superior a modelos hasta 25 veces más grandes.

Google lanzó el pasado jueves su nueva IA multimodal y flexible Gemini, optimizada de forma nativa en tres tamaños para distintas aplicaciones.

Uno de estos formatos es el modelo de lenguaje pequeño, Gemini Nano, con el que permite adaptar las capacidades de IA de forma más eficiente para las tareas de dispositivos como los ‘smartphones’.

Ahora, Microsoft también compartió su intención de trasladar la potencia de los modelos de lenguaje de gran tamaño (LLM) a un tamaño más reducido.

Cabe destacar que estos trabajan con cientos de miles de millones de parámetros, utilizando opciones estratégicas para la capacitación, como es la selección de datos.

MODELO ENFOCADO EN LA INVESTIGACIÓN

En este marco, presentó su nuevo modelo de lenguaje pequeño Phi-2, que cuenta con una capacidad de 2,7 millones de parámetros en un tamaño compacto.

Por otro lado, es importante marcar que alcanza un rendimiento a la par que los modelos de escala mucho más grandes.

Se trata de un modelo enfocado a su uso para la investigación, la interpretación mecanicista o las mejoras de seguridad.

La tecnológica destacó su capacidad para lograr un nivel de razonamiento y comprensión de lenguaje con un rendimiento “igual o superior” que el obtenido por modelos hasta 25 veces más grandes.

Tal y como explicó en un comunicado en su web, el equipo de Microsoft Research estuvo trabajando durante los últimos meses en un conjunto de modelos de lenguaje pequeño (SLM) llamado Phi.

Con este han logrado un rendimiento “notable” en una variedad de labores.

AUMENTO DE CAPACIDADES

Primero, la compañía desarrolló Phi-1, que trabajaba con 1.300 millones de parámetros y pudo lograr un alto rendimiento en codificación Python.

Más tarde, Microsoft actualizó el modelo a Phi-1.5, con el que se obtuvo un rendimiento comparable al de modelos con un tamaño cinco veces mayor.

Finalmente, el equipo de Microsoft Resarch ha lanzado Phi-2 aumentando aún más estas capacidades.

Parte de la novedad de Phi-2 es que puede obtener resultados de razonamiento y comprensión de lenguaje.

Según detallan, permiten tenerlo con un rendimiento “de vanguardia” entre modelos con menos de 13.000 millones de parámetros.

Esto se debe a las innovaciones que logró la compañía en lo relativo al escalado de modelos y al entrenamiento de datos.

TAREAS DE CODIFICACIÓN Y MATEMÁTICAS

Tanto es así que, según han podido comprobar los investigadores de Microsoft, Phi2 ofrece mejores resultados que los modelos Llama 2 de Meta -en los parámetros 7B y 13B- y Mistral.

En concreto, supera el rendimiento de Llama 2 en tareas de razonamiento de varios pasos, como son las tareas relacionadas con la codificación y las matemáticas.

Asimismo, Microsoft también ha puesto en valor que Phi-2 es capaz de igualar e, incluso, superar la IA de Google Gemini Nano, a pesar de que esta última tiene un tamaño más grande.

ENTRENAMIENTO CON DATOS DE CALIDAD DE LIBRO DE TEXTO

Para lograr este rendimiento en un modelo de lenguaje de menor tamaño, la compañía ha detallado que se han enfocado en la calidad de los datos de entrenamiento.

Es decir, según confirmaron, se centraron en entrenar la IA con datos “de calidad de libro de texto”. Concretamente, los datos escogidos para el entrenamiento contienen conjuntos de datos sintéticos.

Informaron que están “creados específicamente para enseñar al modelo razonamiento con sentido común y conocimientos generales”.

Así estos conjuntos de datos incluyen información sobre la ciencia, las actividades diarias y la teoría de la mente, entre otros temas.

Siguiendo esta línea, Microsoft continuó entrenando Phi-2 con datos web “cuidadosamente seleccionados” y filtrados según su valor educativo y su calidad.

MEJOR COMPORTAMIENTO A LAS RESPUESTAS CON TOXICIDAD

Con todo ello, Phi-2 se entrenó durante 14 días utilizando un total de 96 tarjetas gráficas A100 de Nvidia.

Además, Microsoft detalló que se trata de un modelo que no se entrenó con aprendizaje reforzado a partir de la retroalimentación humana (RLHF).

A raíz de esto, se ha observado “un mejor comportamiento” con respecto a los sesgos o a las respuestas con toxicidad.

Por el momento, Phi-2 se ha puesto a disposición de los usuarios como parte del catálogo de modelos de Azure AI Studio, de cara a fomentar la investigación y el desarrollo de modelos de lenguaje.

Fuente: EP.